Dankzij OpenAI is het een erg drukke week geweest voor AI-nieuws, waaronder een controversiële blogpost van CEO Sam Altman, de wijdverbreide uitrol van Advanced Voice Mode, geruchten over 5GW-datacenters, grote personeelswisselingen en opwindende herstructureringsplannen.

Maar de rest van de AI-wereld houdt geen gelijke tred, doet zijn eigen ding en produceert met de minuut nieuwe AI-modellen en onderzoek. Hier is een samenvatting van ander opmerkelijk AI-nieuws van de afgelopen week.

Google Gemini-updates

Googlen op dinsdag Kondig aan Updates voor het Gemini-modellengamma, inclusief de release van twee nieuwe productieklare modellen die voortbouwen op eerdere versies: Gemini-1.5-Pro-002 en Gemini-1.5-Flash-002. Het bedrijf rapporteerde verbeteringen in de algehele kwaliteit, met opmerkelijke winst op het gebied van wiskunde, verwerking van lange contexten en visietaken. Google claimt een prestatieverbetering van 7 procent op MMLU-Pro standaard en een verbetering van 20 procent in wiskundegerelateerde taken. Maar zoals je weet, als je Ars Technica al een tijdje leest, zijn AI-standaarden doorgaans niet zo nuttig als we zouden willen.

Samen met de modelupgrades introduceerde Google aanzienlijke prijsverlagingen voor de Gemini 1.5 Pro, waardoor de kosten voor invoercodes met 64 procent en de kosten voor uitvoercodes met 52 procent werden verlaagd voor claims onder de 128.000 codes. Zoals AI-onderzoeker Simon Willison zei mannelijk Op zijn blog: “Ter vergelijking: GPT-4o kost momenteel $5/[million tokens] De input en output zijn $15/m en de Claude 3.5 Sonnet is $3/m input en $15/m output. De Gemini 1.5 Pro was al de goedkoopste van de frontiermodellen en is nu nog goedkoper.”

Google heeft ook de prijslimieten verhoogd: Gemini 1.5 Flash ondersteunt nu 2.000 verzoeken per minuut en Gemini 1.5 Pro verwerkt 1.000 verzoeken per minuut. Google merkt op dat de nieuwste modellen tweemaal de uitvoersnelheid en driemaal lagere latentie bieden dan eerdere versies. Deze veranderingen kunnen het voor ontwikkelaars eenvoudiger en kosteneffectiever maken om apps met Gemini te bouwen dan voorheen.

Meta brengt Llama 3.2 uit

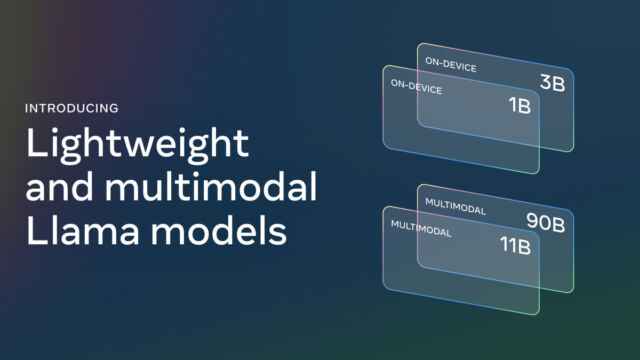

Woensdag was hij dood Kondig aan Llama 3.2 is uitgebracht, een belangrijke update van de reeks AI-modellen met open gewicht die we in het verleden uitgebreid hebben besproken. De nieuwe release bevat vision-capabele grote taalmodellen (LLM’s) met parametergroottes van 11B en 90B, evenals lichtgewicht modellen met alleen tekst met 1B- en 3B-parameters ontworpen voor edge- en mobiele apparaten. Meta beweert dat de vision-modellen concurrerend zijn met toonaangevende closed-source-modellen op het gebied van beeldherkenning en visueel begrip, terwijl de kleinere modellen naar verluidt beter presteren dan concurrenten van vergelijkbare grootte op verschillende op tekst gebaseerde taken.

Willison heeft enkele tests uitgevoerd op enkele van de kleinere 3.2f-modellen Rapporteerde indrukwekkende resultaten Voor maatmodellen. Onderzoeker op het gebied van kunstmatige intelligentie Ethan Mollick Show Hij draaide Llama 3.2 op zijn iPhone met behulp van een app genaamd PocketPal.

Meta introduceerde ook de eerste officiële”Lama stapelDistributies, gemaakt om de ontwikkeling en implementatie in verschillende omgevingen te vereenvoudigen, net als bij eerdere releases, biedt Meta sjablonen die gratis kunnen worden gedownload, met licentiebeperkingen. De nieuwe sjablonen ondersteunen lange contextvensters van maximaal 128.000 tokens.

De AlphaChip AI-technologie van Google versnelt het chipontwerp

Op donderdag Google DeepMind Kondig aan Wat een grote vooruitgang lijkt te zijn in het ontwerp van op AI gebaseerde microchips, AlphaChip. Ik begon als Onderzoeksproject Anno 2020 is het nu een versterkende leermethode voor het ontwerpen van dia-indelingen. Google heeft naar verluidt AlphaChip gebruikt om ‘superchip-lay-outs’ te creëren in de afgelopen drie generaties Tensorverwerkingseenheden (TPU’s), dit zijn chips die lijken op grafische verwerkingseenheden (GPU’s) die zijn ontworpen om AI-bewerkingen te versnellen. Google beweert dat AlphaChip in enkele uren dia-indelingen van hoge kwaliteit kan maken, vergeleken met weken of maanden menselijke inspanning. (Nvidia heeft dat naar verluidt gedaan Er is ook gebruik gemaakt van kunstmatige intelligentie Om te helpen bij het ontwerpen van hun chips.)

Google heeft met name ook een Voorgetraind controlepunt Van AlphaChip op GitHub, en deel de modelgewichten met het publiek. De invloed van AlphaChip strekt zich al uit tot buiten Google, met soortgelijke chipontwerpbedrijven, aldus het bedrijf mediatek De technologie voor hun chips overnemen en erop voortbouwen. Volgens Google heeft AlphaChip een nieuwe onderzoekslijn gelanceerd naar kunstmatige intelligentie voor chipontwerp, die elke fase van de chipontwerpcyclus, van computerarchitectuur tot productie, zou kunnen verbeteren.

Dat is nog niet alles, maar hier zijn enkele hoogtepunten. Nu de AI-industrie op dit moment geen tekenen van vertraging vertoont, zullen we zien hoe volgende week afloopt.

More Stories

Apple kondigt uitbreiding van Vision Pro naar nog twee landen aan

Hoe u de Apple Gehoortest doet met AirPods Pro 2

Apple kondigt MacBook Pro-modellen aan met M4 Pro- en M4 Max-chips, Thunderbolt 5-ondersteuning en meer