De twee grootste AI-startups ter wereld negeren de verzoeken van media-uitgevers om te stoppen met het verzamelen van gratis voorbeeldtrainingsgegevens van hun webcontent, zo heeft Business Insider vernomen.

OpenAI en Anthropic bleken een statische webregel genaamd robots.txt, die het automatisch verwijderen van websites verhindert, te negeren of te omzeilen.

TollBit, een startup die zich richt op het bemiddelen in betaalde licentieovereenkomsten tussen uitgevers en AI-bedrijven, ontdekte dat veel AI-bedrijven zich op deze manier gedroegen en heeft vrijdag enkele grote uitgevers in een brief op de hoogte gebracht. Dat meldde Reuters eerder. De brief bevatte niet de namen van de kunstmatige-intelligentiebedrijven die ervan werden beschuldigd de regel te omzeilen.

OpenAI en Anthropic hebben publiekelijk verklaard dat ze het robots.txt-bestand respecteren en hun eigen webcrawlers, zoals GTBot en ClaudeBot, blokkeren.

Volgens de bevindingen van TollBit worden dergelijke blokkades echter niet gerespecteerd, zoals wordt beweerd. AI-bedrijven, waaronder OpenAI en Anthropic, kiezen ervoor om het robots.txt-bestand eenvoudigweg te ‘omzeilen’ om alle inhoud van een bepaalde website of pagina op te halen of te extraheren.

Een woordvoerster van OpenAI weigerde commentaar te geven op de richtlijnen van BI aan een bedrijf Blogpost Vanaf mei zegt het bedrijf dat het rekening houdt met webcrawler-machtigingen “elke keer dat we een nieuw model trainen.” Een woordvoerder van Anthropic reageerde niet op e-mails waarin om commentaar werd gevraagd.

Robots.txt is een stukje code dat sinds eind jaren negentig wordt gebruikt als een manier voor websites om robotcrawlers te vertellen dat ze niet willen dat hun gegevens worden verwijderd en verzameld. Het is algemeen aanvaard als een van de onofficiële ondersteunende regels van het internet.

Met de komst van generatieve AI racen startups en technologiebedrijven om de krachtigste AI-modellen te bouwen. Het belangrijkste ingrediënt is data van hoge kwaliteit. De honger naar dergelijke trainingsgegevens heeft robots.txt en de informele conventies die het gebruik van deze code ondersteunen, ondermijnd.

OpenAI zit achter de populaire chatbot ChatGPT. De grootste investeerder van het bedrijf is Microsoft. Anthropic zit achter een andere relatief populaire chatbot, Claude. De grootste investeerder is Amazon.

Beide chatbots geven op menselijke toon antwoord op gebruikersvragen. Dergelijke antwoorden zijn alleen mogelijk omdat de AI-modellen waarop ze zijn gebouwd enorme hoeveelheden geschreven tekst en gegevens bevatten die van internet zijn gehaald, waarvan de meeste auteursrechtelijk beschermd zijn of eigendom zijn van de makers ervan.

Verschillende technologiebedrijven betoogden vorig jaar voor het Amerikaanse Copyright Office dat niets op internet als auteursrechtelijk beschermd mag worden beschouwd als het gaat om AI-trainingsgegevens.

OpenAI heeft een aantal deals met uitgevers om toegang te krijgen tot inhoud, waaronder Axel Springer, eigenaar van BI. Het Amerikaanse Copyright Office zal later dit jaar zijn richtlijnen over kunstmatige intelligentie en auteursrecht bijwerken.

Bent u een tech-medewerker of iemand anders die advies of inzicht heeft om te delen? Neem contact op met Callie Hayes [email protected] Of op een beveiligde berichten-appSignaal Op +1-949-280-0267. Communiceer via een niet-werkapparaat.

“Bierliefhebber. Toegewijde popcultuurgeleerde. Koffieninja. Boze zombiefan. Organisator.”

More Stories

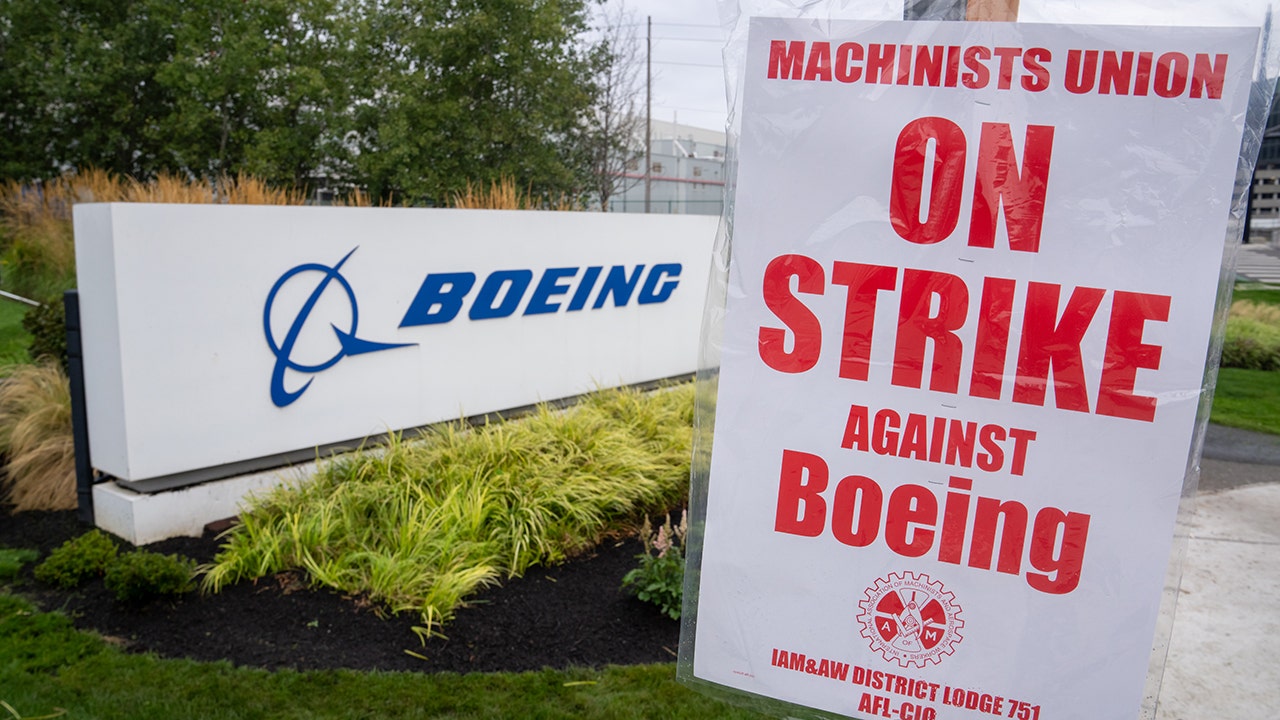

Boeing begint met ontslagen te midden van vakbondsstaking en controverse over de aankoop van een huis door de CEO: ‘Zeer moeilijke tijden’

Amerikaanse aandelen blijven in afwachting van het besluit van de Federal Reserve

President Fine van de vakbond United Auto Workers kondigt stakingsplannen aan bij Stellantis